EDIT DU 22/07 : Le règlement européen sur l’IA (ou AI Act) vient d’être publié au Journal officiel de l’Union européenne (JOUE) le 12 juillet dernier et entrera progressivement en application à partir du 1er aout 2024.

Aujourd’hui l’intelligence artificielle prend une place de plus en plus conséquente dans le quotidien de nombreux français. Il devient alors important de régulariser son usage et sa mise en œuvre. Le règlement européen sur l’IA (RIA) est donc la première législation générale (ou exhaustive) au monde sur l’intelligence artificielle.

Pierre-Yves Lastic, vice-président de l’Union des DPO et ancien Deputy Head en charge de la Global privacy office au sein du groupe Sanofi, est intervenu lors de notre webinar « L’Artificial Intelligence Act : quels impacts pour les entreprises ». Dans cet article nous reprenons les termes abordés lors de ce webinar afin de mieux comprendre l’AI ACT.

Pourquoi règlementer l’usage de l’intelligence artificielle ?

Depuis toujours, l’intelligence artificielle a su nous montrer deux facettes : alors qu’elle peut se montrer très utile dans la vie quotidienne et professionnelle, l’IA peut aussi présenter des risques. Connue pour être complexe, imprévisible elle est aussi par définition, autonome et autodidacte.

Ces caractéristiques font que l’IA peut d’une manière ou d’une autre, porter atteinte à nos droits fondamentaux mais aussi causer des incertitudes juridiques.

Prenons l’exemple d’un accident lié à une voiture autonome, qui sera responsable : le conducteur, la voiture, le constructeur ?

C’est au vu de tous ces aspects, que l’Union Européenne a décidé de réglementer l’usage et la mise en œuvre de l’intelligence artificielle.

Qu’est-ce que le projet de loi AI Act ?

« L’AI Act est une proposition du règlement du parlement européen et du conseil établissant des règles harmonisées en matière d’IA. »

Cette réglementation se veut neutre et a pour objectif de couvrir toute l’intelligence artificielle, y compris l’IA symbolique traditionnelle, le machine learning et les systèmes hybrides. Le règlement liste de longues annexes souvent mises à jour et contenant la liste des techniques et approches que l’IA devrait assurer au fil du temps.

Pour en savoir plus : https://artificialintelligenceact.eu/fr/ai-act-explorer/

Comment l’intelligence artificielle sera réglementée via l’AI Act ?

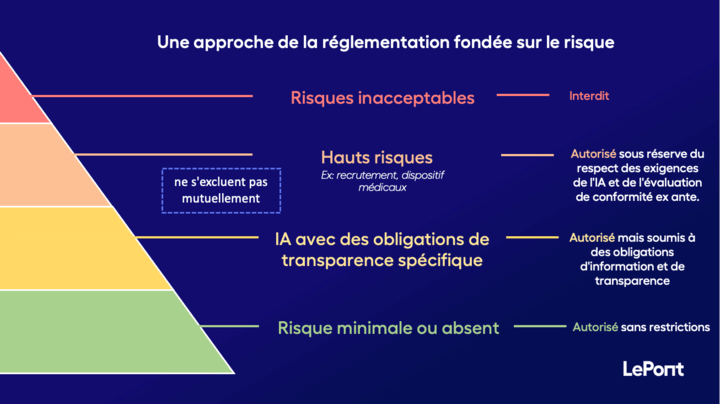

La commission propose une approche fondée sur quatre niveaux de risques.

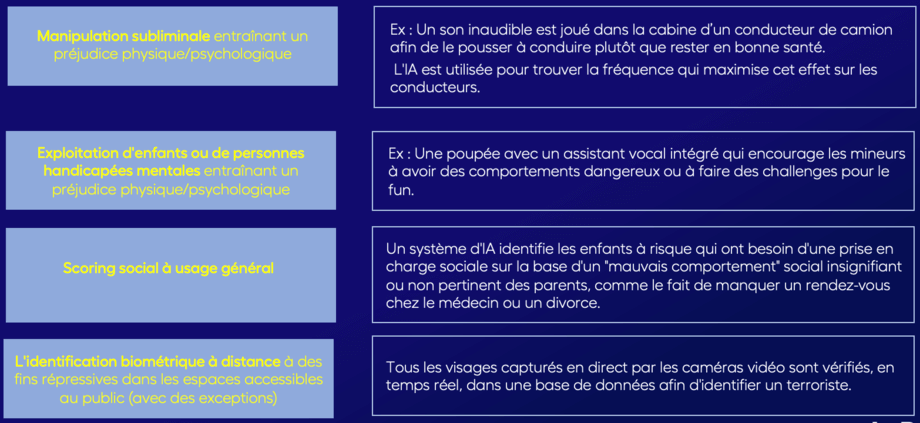

Niveau 4 : les risques inacceptables

En haut de la pyramide, nous avons les risques inacceptables au regard des valeurs de l’UE. Ce sont des systèmes d’IA qui iraient contre les droits fondamentaux et leur application serait donc interdite. À noter, une liste des applications d’IA interdites sera régulièrement mise à jour et disponible en ligne.

Parmi les risques inacceptables, nous pouvons retrouver les exemples suivants :

Niveau 3 : les hauts risques

Autre niveau de cette pyramide, il s’agit des applications d’IA à haut risques. Dans cette catégorie nous allons retrouver les systèmes d’IA qui vont conditionner le recrutement (pour éviter toute discrimination), les dispositifs médicaux (car il en va de la sécurité d’un patient). Tous ces systèmes devront être soumis à une évaluation avant mise en œuvre du système.

Niveau 2 : les IA avec des obligations de transparence spécifique

En second niveau, nous retrouvons les systèmes d’IA qui se veulent moins dangereux, et causant moins de risques pour les utilisateurs. Ce type de système sont autorisé mais soumis à des obligations d’information et de transparence. Ces obligations seront expliquées à la question suivante. Dans ce niveau, nous retrouverons les IA intégrées dans des chabot ou des conversation téléphonique de type numéro vert.

Niveau 1 : le risque minimal ou absents

Enfin, le dernier étage de notre pyramide, regroupe les systèmes où l’on suggère que le risque est minime et/ou absent (ex : une machine à laver qui utiliserait un système d’intelligence artificielle). Pour tout système présent dans cette catégorie, aucune pré-évaluation ne sera demandée.

Quelles obligations dois-je respecter avant de commercialiser mon produit IA ?

Pour les systèmes où l’on estime que le risque est minimal ou absent, les obligations ne seront pas lourdes ou contraignantes. La Commission et le Conseil encouragent l’élaboration de codes de conduite destinés à favoriser l’application volontaire des exigences liées aux systèmes d’IA à faible risque.

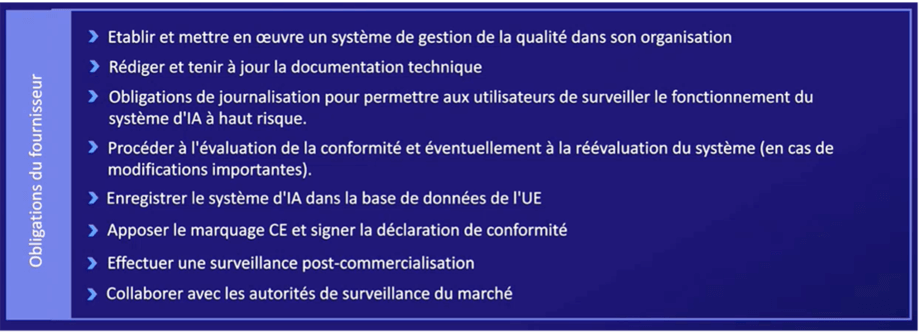

Néanmoins, l’article 52 stipule certaines obligations de transparence pour certains systèmes d’IA. Pour les systèmes à haut risques par exemples, les obligations sont les suivantes :

- Notifier les personnes qu’elles sont en train d’interagir avec une IA sauf si cela est évident. On ne parle pas ici d’aspirateur robot ou de réfrigérateur utilisant une IA mais plutôt de systèmes utilisant des IA conversationnelles telle que les chatbots ou des avatars vidéo. C’est bien dans ce type de cas, qu’il est obligatoire d’informer l’utilisateur.

- Notifier les personnes qu’elles sont soumises à des systèmes de reconnaissance émotionnelle ou de catégorisation biométrique.

- Appliquer un marquage aux « deep fakes » (sauf si cela est nécessaire à l’exercice d’un droit ou d’une liberté fondamentale ou pour des raisons d’intérêt public).

- Appliquer le marquage CE afin de prouver que le produit est conforme aux exigences de la législation de l’Union Européenne et signer une déclaration de conformité. Ces documents sont à retrouver sur le site de l’Union Européenne ou de la commission.

Voici quelques exemples d’obligations :

A noter, la CNIL a mis en ligne un guide permettant à tout un chacun d’effectuer une auto-évaluation de son produit afin de voir si ce dernier est conforme au règlement AI Act.

Quelles sont les recommandations à suivre avant de commercialiser un système d’IA ?

Selon, Pierre-Yves Lastic, pour vous assurer que votre système d’IA corresponde aux exigences relatives liées aux risques, le mieux serait « d’établir et de mettre en œuvre des processus de gestion des risques pertinents au vu de la finalité du système d’IA ». Pour ce faire, vous pouvez suivre les points suivants :

- Utiliser des données de formation, de validation et d’essai de haute qualité (pertinentes, représentatives, etc.).

- Documenter l’ensemble du développement et des tests du système et mettre en place une journalisation de son fonctionnement (traçabilité et auditabilité). Vous devez être capable de remonter la chaîne de décisions afin de déterminer d’où provient le dysfonctionnement de départ.

- Assurer un degré de transparence approprié pour expliquer aux utilisateurs le fonctionnement du système. En d’autres termes, indiquer à l’utilisateur s’il interagit avec une IA lorsque ce n’est pas évident.

- Assurer un contrôle humain (mesure intégrée au système et/ou à mettre en œuvre par les utilisateurs).

- Assurer la robustesse, l’exactitude et la cybersécurité de votre système.

Enfin, en fonction de la taille de votre structure, il est fortement recommandé de faire appel à une équipe de juriste ou à un Data protection officer à plein temps. Pour les plus petites entreprises, des cabinets spécialisés peuvent aussi vous venir en aide pour éviter la production et la mise en œuvre d’un système d’IA non conforme à l’AI Act.

Quelles sont les sanctions encourues si je ne respecte pas les obligations et recommandations citées précédemment ?

Deux cas s’offrent à vous :

Si vous êtes dans la situation où vous avez commercialisé un produit sans marquage CE. Les sanctions peuvent être civiles mais aussi administratives allant donc de quelques centaines d’euros d’amende à des années de prison en fonction du produit commercialisé et du dommage causé.

Pour toute autre entrave à la réglementation de l’intelligence artificielle ACT, les sanctions encourues vont suivre la même logique que la règlementation RGPD. Les amendes pourront alors s’élever à des millions d’euros ou à un certain pourcentage du chiffre d’affaires de votre entreprise.

Bonus :Quand le RIA entre-t-il en application ?

A noter cette question n’a pas été répondue par Pierre Yves Lastic.

Publié au Journal officiel le 12 juillet 2024, le RIA entrera en vigueur 24 jours après, soit le 1er août 2024. L’entrée en application se fera ensuite de façon échelonnée :

- 2 février 2025 (6 mois après l’entrée en vigueur) : interdictions relatives aux systèmes d’IA présentant des risques inacceptables.

- 2 août 2025 (12 mois après l’entrée en vigueur) : application des règles pour les modèles d’IA à usage général et nomination des autorités compétentes au niveau des États membres.

- 2 août 2026 (24 mois après l’entrée en vigueur) : toutes les dispositions du règlement sur l’IA deviennent applicables et mise en œuvre par les autorités des États membres d’au moins un bac à sable réglementaire.

- 2 août 2027 (36 mois après l’entrée en vigueur) : application des règles relatives aux systèmes d’IA à haut risque de l’annexe I.

Pour aller plus loin :

- Visionnez le replay de notre dernier webinar sur le sujet 👉 c’est ici

- Le 6 décembre dernier, le Conseil de l’Europe a examiné le projet de règlement afin d’adopter une position commune à retrouver dans cet article : https://www.consilium.europa.eu/en/press/press-releases/2022/12/06/artificial-intelligence-act-council-calls-for-promoting-safe-ai-that-respects-fundamental-rights/

- Si vous souhaitez en apprendre plus sur les conséquences de cette proposition de réglementation pour les start-up européennes, n’hésitez pas à lire cette enquête à retrouver sur le lien suivant : https://aiaustria.com/news/impact-of-the-ai-act-on-the-european-ai-startup-market

Cela pourrait vous intéresser

Connect

Pour recevoir nos derniers articles sur la Data et l'Intelligence Artificielle, abonnez vous à Connect, l’email qui fait du bien à vos données.

Vous souhaitez plus d'actualités exclusives sur la data et l'IA ?

Inscrivez-vous à notre newsletter mensuelle Connect ! Recevez une fois par mois un concentré d’actualités, événements, interviews, documentation sur les domaines data, IA et Cybersécurité.